Le premier microprocesseur commercialisé, l’Intel 4004, a été lancé en 1971 avec une architecture à 4 bits et une fréquence de 740 kHz. Son développement ne répondait initialement pas à une demande du secteur informatique, mais à celle d’un fabricant japonais de calculatrices.

Malgré des ressources limitées, ce circuit intégré a ouvert la voie à une révolution technologique. L’apparition du 4004 marque le point de bascule où la logique câblée laisse place à la programmation logicielle, modifiant durablement les méthodes de conception des machines électroniques.

Aux origines de l’informatique : quand tout commence

L’histoire de l’informatique s’écrit à coups de ruptures majeures, et l’ENIAC en est la première déflagration. Conçue par John Mauchly et J. Presper Eckert dans l’urgence de la Seconde Guerre mondiale, cette bête de métal et de tubes à vide, pesant des tonnes, pose la toute première pierre de l’architecture moderne. Puis vient le UNIVAC : même équipe, autre vision. Cette fois, les machines quittent les laboratoires militaires pour entrer dans les bureaux des administrations et des entreprises, marquant le début de l’informatique au service du public.

Mais l’avancée technique ne suffit pas. Il fallait aussi une révolution du code. Grace Hopper s’y attelle avec le COBOL. Elle ne se contente pas d’inventer un langage : elle ouvre la porte de la programmation à ceux qui n’avaient jamais touché une machine. Automatiser la gestion, structurer la pensée algorithmique : son héritage irrigue chaque évolution, des premiers mainframes jusqu’aux objets connectés.

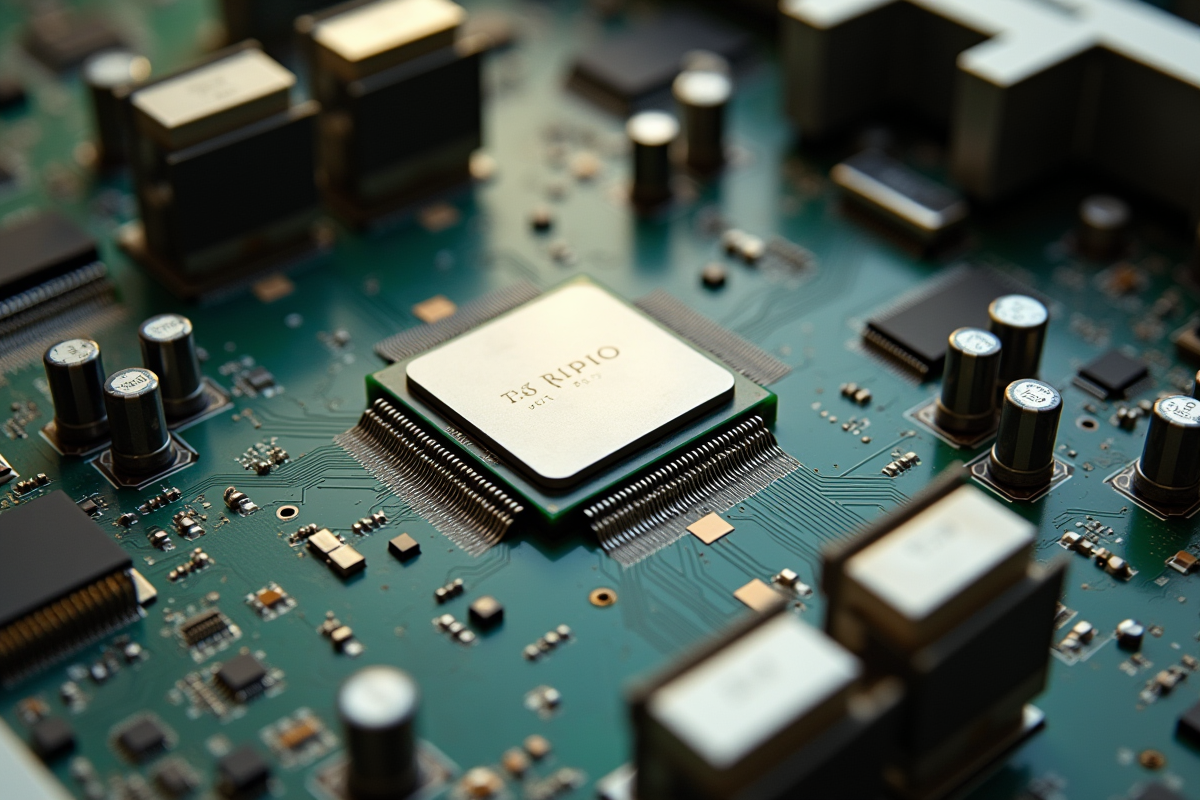

Le matériel suit, de plus en plus vite. Robert Noyce, à l’origine de Fairchild Semiconductor puis d’Intel, perfectionne le circuit intégré monolithique, catalyseur de la miniaturisation qui va tout changer. Le transistor classique s’efface peu à peu devant le Transistor MOS, mis au point par Mohamed Italia et Dawn Kahng, avant d’évoluer en MOSFET. Ce composant, aujourd’hui omniprésent, sera le socle de la microélectronique, rendant possible l’intégration massive de fonctions dans un espace minuscule.

Voici quelques jalons qui ont balisé cette ascension :

- ENIAC : premier ordinateur électronique programmable

- COBOL : standardise le développement logiciel

- MOSFET : fondement de la microélectronique moderne

L’addition de ces avancées, du calculateur géant au minuscule circuit intégré, dessine la trajectoire directe vers le microprocesseur. Ce n’est plus une affaire de prototypes : l’informatique s’apprête à bouleverser l’industrie, puis la société tout entière.

Quel est le tout premier processeur d’ordinateur ?

1971. L’année où tout bascule. Intel dévoile le premier microprocesseur commercialisé : l’Intel 4004. Derrière ce fragment de silicium, une petite équipe menée par Ted Hoff, Masatoshi Shima, Stanley Mazor et Federico Faggin réalise l’impensable : réunir une unité centrale complète sur une seule puce à peine plus grande qu’un ongle. 2 300 transistors, une architecture 4 bits, une fréquence de 740 kHz, une capacité de calcul de 0,06 MIPS, ce sont les chiffres bruts qui amorcent la révolution.

Ce processeur n’est pas le fruit d’un projet interne mais d’une commande de la société japonaise Busicom, désireuse de sortir une calculatrice compacte, la 141-PF. Intel, sous la houlette de Faggin, sort des schémas traditionnels : au lieu d’assembler des circuits spécialisés, ils misent sur un microprocesseur programmable, capable de s’adapter à différents usages. Cette bascule technique pose les bases de la miniaturisation et de la programmabilité universelle : deux moteurs qui propulseront l’informatique sur tous les fronts.

| Modèle | Année | Architecture | Transistors | Fréquence |

|---|---|---|---|---|

| Intel 4004 | 1971 | 4 bits | 2 300 | 740 kHz |

Bien plus qu’une simple étape dans la saga Intel, le 4004 va inspirer toute une génération d’ordinateurs personnels, de systèmes embarqués, d’outils industriels. Il crée une nouvelle syntaxe pour l’informatique, une matrice dont s’inspireront toutes les architectures à venir.

Des innovations techniques qui ont bouleversé la conception des machines

L’aventure technique ne s’arrête pas au 4004. Chaque nouvelle génération de processeurs renverse la donne, repousse les limites. 1974 : l’Intel 8080 débarque et propulse l’Altair 8800 de MITS sur le devant de la scène. Pour la première fois, un microprocesseur exécute un véritable système d’exploitation, CP/M, et attire des esprits brillants comme Bill Gates et Paul Allen, qui conçoivent un compilateur BASIC pour cette machine. Le mythe de l’ordinateur personnel prend forme.

Pendant ce temps, la diversité des architectures explose. Le Motorola MC68000 introduit les 32 bits, propulsant l’Apple Macintosh et l’Atari vers des sommets de puissance graphique et sonore. Sun Microsystems impose le SPARC. En 1987, Acorn Computers lance la première puce ARM, qui va largement influencer l’informatique mobile et embarquée.

Voici les grandes tendances qui ont redéfini le secteur :

- Miniaturisation : le 4004 initie l’intégration verticale, une dynamique reprise et amplifiée par Fairchild, IBM ou encore AMD.

- Démocratisation : la baisse des coûts rend l’ordinateur personnel et l’électronique accessible à tous.

- Programmabilité : la flexibilité des architectures généralistes, associée à des systèmes d’exploitation comme CP/M ou DOS, stimule l’innovation logicielle.

Quand le Pentium voit le jour, suivi du PowerPC 601 développé par Apple, IBM et Motorola, vitesse et polyvalence deviennent la norme. Les fondeurs comme Intel ou AMD affinent la gravure, multiplient les cœurs, ouvrant de nouveaux horizons : calcul scientifique, graphisme, intelligence artificielle.

L’héritage des pionniers : comment les premiers processeurs ont façonné l’informatique moderne

Ce n’est pas qu’une affaire de performances : la loi de Moore, énoncée par Gordon Moore, va rythmer toute l’histoire de la microélectronique. En doublant le nombre de transistors tous les 18 à 24 mois, les industriels inscrivent la croissance exponentielle dans leur ADN. Intel, AMD, ARM : tous cherchent à repousser les frontières de la miniaturisation, de l’efficacité, de la puissance.

Le résultat ? Aujourd’hui, les processeurs atteignent des milliards d’opérations à la seconde, embarquent plusieurs cœurs, et la finesse de gravure passe sous la barre des 10 nanomètres. Les gammes Core i7 et Core i9 en sont la démonstration : caches volumineux, pipelines d’exécution complexes, gestion de l’out-of-order execution pour exploiter chaque cycle d’horloge.

Dans les centres de recherche, cette puissance change la donne. Au CERN, les calculateurs du LHC analysent des torrents de données grâce à ROOT et PROOF, exploitant au maximum les architectures multicœurs. Les exigences du calcul scientifique, du big data ou de l’intelligence artificielle guident la conception des nouveaux processeurs, où performance énergétique et parallélisme sont devenus incontournables.

La variété des architectures s’est imposée comme une évidence : instruction réduite (RISC), percée d’ARM dans les terminaux mobiles et chez Apple, adaptation des puces aux usages précis, mobiles, serveurs, objets connectés. Les pionniers ont transmis un héritage vivant : chaque processeur actuel porte la mémoire des premiers, tout en repoussant sans relâche le champ des possibles. Un mouvement perpétuel, où chaque innovation dessine déjà la prochaine étape de l’informatique.